Entrevista: os impactos das tecnologias “smart” na vida das pessoas negras e trans

A historiadora Mariah Rafaela Silva mostra como tecnologias replicam e acentuam desigualdades de raça e gênero

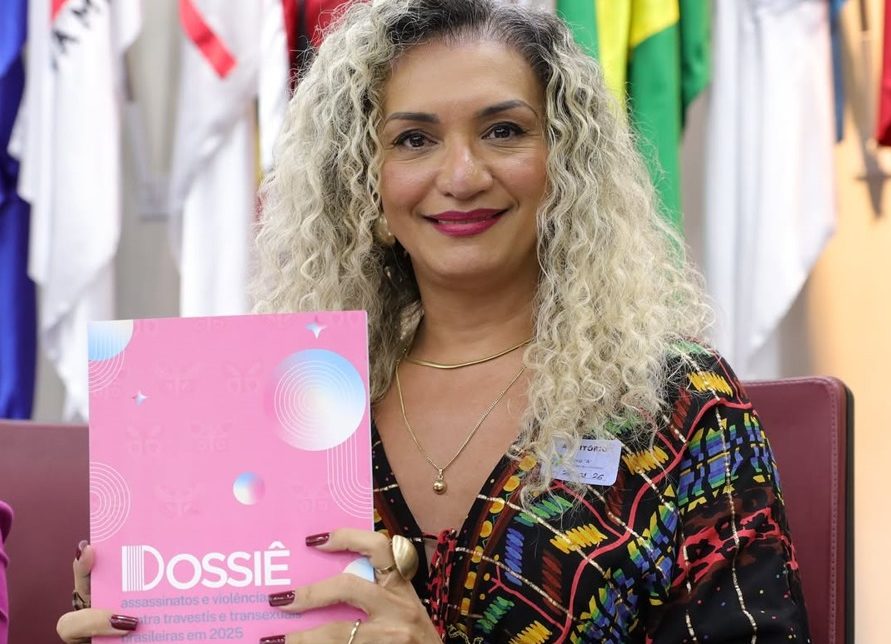

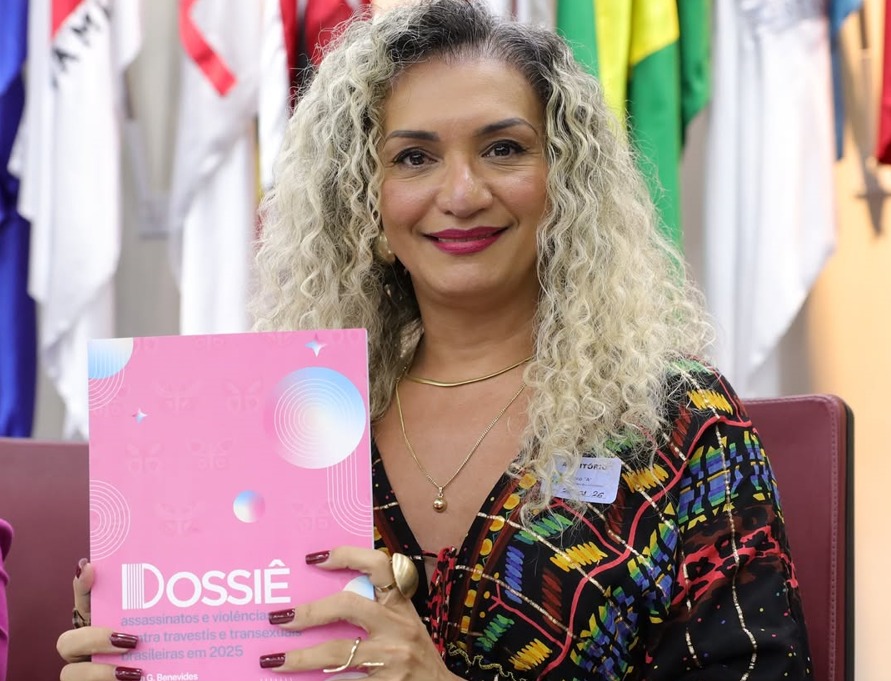

Produzidas a partir de contextos sociais marcados pelo racismo e transfobia, as chamadas tecnologias “smart”, como programas de reconhecimento facial utilizados na segurança pública em diferentes partes do mundo, podem aprofundar ainda mais as desigualdades raciais de gênero. Enfrentar este problema começa por reconhecer que estas tecnologias não são neutras e atendem a interesses diversos. Essa é uma das reflexões que a historiadora Mariah Rafaela Silva apresenta no artigo “Orbitando telas: tecnopolíticas de segurança, o paradigma smart e o vigilantismo de gênero em tempos de acumulação de dados”, publicado na edição 31 da Revista Sur.

Mariah Rafaela Silva é formada em História da Arte, possui mestrado em História, Teoria e Crítica da Cultura e é doutoranda em Comunicação pela Universidade Federal Fluminense. Além disso, já atuou como professora do Departamento de História e Teoria da Arte da Universidade Federal do Rio de Janeiro e estudou gênero, migração e globalização na Universidade Nova de Lisboa. Ela também é ativista social e colaboradora em O Panóptico. Mariah foi uma das quatro bolsistas da edição 31 da Revista Sur. Para a Conectas, ela traz alguns elementos de seu texto.

Acompanhe a entrevista:

Conectas: Comente sobre seu texto. Quais reflexões ele apresenta?

Mariah Rafaela Silva – Trabalho há mais de dez anos com direitos humanos e, ultimamente, pesquiso tecnologias biométricas, como reconhecimento facial, leitura de retina e outras tecnologias chamadas “smart”, para pensar como elas impactam nas experiências de indivíduos marginalizados – especificamente mulheres negras, mulheres transexuais e pessoas LGBTI em territórios de favelas. No texto, trago um pouco desse trabalho, dos meus debates com outros pesquisadores, com outros teóricos e com outros ativistas para pensar como que essas tecnologias “smart” vão ganhando um caráter político e, a partir disso, configurando e automatizando um certo processo de subjetivação na sociedade, sobretudo no que diz respeito a transexuais, travestis e mulheres transexuais. Olho também como que essas tecnologias vão ditando uma normativa, uma pragmática de vida, a partir de um conjunto de modelos de vigilância – vigilância de dados, de vigilância no sistema de internet, câmeras de vigilância. [Analiso], portanto, como tudo isso permeia a nossa subjetividade.

Leia mais

Conectas: De que forma as tecnologias de vigilância discriminam pessoas trans e racializadas?

Mariah Rafaela Silva – Toda tecnologia tem caráter político. Por causa disso e, obviamente, de outras questões mais densas, as tecnologias não são neutras. Elas têm uma historicidade, ou seja, elas também dependem de certas narrativas e determinados interesses, principalmente econômicos e, claro, hegemônicos para sua regimentação. É aí que elas impactam na vida de pessoas travestis, transexuais e pessoas negras. Por quê? Porque há racismo e transfobia estruturando os modos de relação social e isso reflete em como as tecnologias traduzem ou reiteram esses processos que já estavam na sociedade. Ou seja, uma sociedade que é estruturada a partir de determinadas lógicas, determinados movimentos racistas e transfóbicos, quando constrói suas tecnologias, elas tendem a refletir esses mesmos princípios. Por exemplo, no que diz respeito às tecnologias biométricas, especificamente a tecnologia de reconhecimento facial, os algoritmos são configurados para que os rostos de pessoas negras, em geral, não sejam lidos com facilidade. No caso dos rostos das pessoas trans, estas máquinas tendem a agir de maneira binária. Quando essas tecnologias começam a ser aplicadas no escopo da segurança, é preciso ter muito cuidado com essa alta margem de erro, que chamamos de falsos positivos. A maior parte dos erros acontecem com pessoas negras e com pessoas transexuais. Alguns exemplos: pessoas que são encaminhadas para delegacia e são presas porque a máquina identificou aquela pessoa como culpada de um crime que ela não cometeu ou pessoas trans quando tentam validar documentos não conseguem porque dá erro ou conflito de identidade.

Conectas: Como que a sociedade civil/organizações de direitos humanos podem atuar para amenizar esse cenário e conseguir defender as diversidades e democracia dentro dos problemas que você levantou?

Mariah Rafaela Silva – A sociedade civil tem um papel fundamental, mas ela precisa ser convocada ao debate. Essas tecnologias são vendidas a partir de determinados interesses e são vendidas como miraculosas para a segurança. No discurso, parece tudo lindo, funciona tudo maravilhoso, mas, na verdade, não é. O que não se fala é o custo dessas tecnologias para a própria segurança das pessoas quando há equívocos. As organizações da sociedade civil têm um dever ético de se posicionar contra isso, contra o discurso, o lobby exclusivamente em torno da segurança. Tem que haver um processo de transparência para a implementação dessas tecnologias que apresente à população os prós e os contras. O esforço das organizações deve ser de atingir e de criar linguagens que sejam efetivas para aquelas pessoas que, de fato, estão fornecendo muitos dados e têm menos meios ou recursos de construir ou de contratar equipamentos de proteção. Seja no seu dispositivo pessoal, como seu celular, computador, relógio… seja quando você usa as suas informações bancárias. Com isso, criamos uma cultura de debate, um debate honesto, um debate franco e transparente sobre os impactos efetivos.